GPT-OSS es la nueva línea de modelos open-weight de OpenAI, disponible bajo la flexible licencia Apache 2.0 para uso personal y comercial OpenAI. Incluye gpt-oss-120b y gpt-oss-20b, diseñados para ofrecer capacidades de razonamiento al nivel de los modelos patentados, pero ejecutándose en tu propio equipo sin costos de API ni dependencias de la nube.

¿Qué es GPT-OSS?

GPT-OSS reúne dos modelos de lenguaje de peso abierto que OpenAI ha liberado para que cualquier desarrollador pueda descargarlos y ejecutarlos localmente bajo Apache 2.0 OpenAI. Esto significa total libertad para personalizar, ajustar y utilizar la IA sin cargos por consumo ni restricciones de infraestructura externa

¿Qué es Apache 2.0?

Apache 2.0 es una licencia de software libre que permite usar, copiar, modificar y distribuir un programa (incluso con fines comerciales) sin pagar nada, siempre que:

- Mantengas el aviso de copyright y la licencia original en los archivos.

- No reclames que el proyecto modificado sigue siendo idéntico al original (debes indicar cambios).

- Recibas y concedas patentes relacionadas al código, pero protegiendo al autor de demandas.

En la práctica, con Apache 2.0 puedes descargar el código, adaptarlo a tu proyecto y compartirlo, sin ataduras más allá de conservar la atribución y cumplir esos puntos.

Características principales

Las claves de GPT-OSS son rendimiento, flexibilidad y cero costos de ejecución local.

- Licencia Apache 2.0: permite uso comercial y personal sin ataduras.

- Modelos 120B y 20B: 117 B y 21 B de parámetros totales, respectivamente, con arquitectura MoE y atención optimizada.

- CoT y tool use: soporta razonamiento en cadena (Chain-of-Thought) y llamadas a funciones para integrarse en flujos de agentes.

Comparativa: gpt-oss-120b vs gpt-oss-20b

Elige según tus recursos y necesidades:

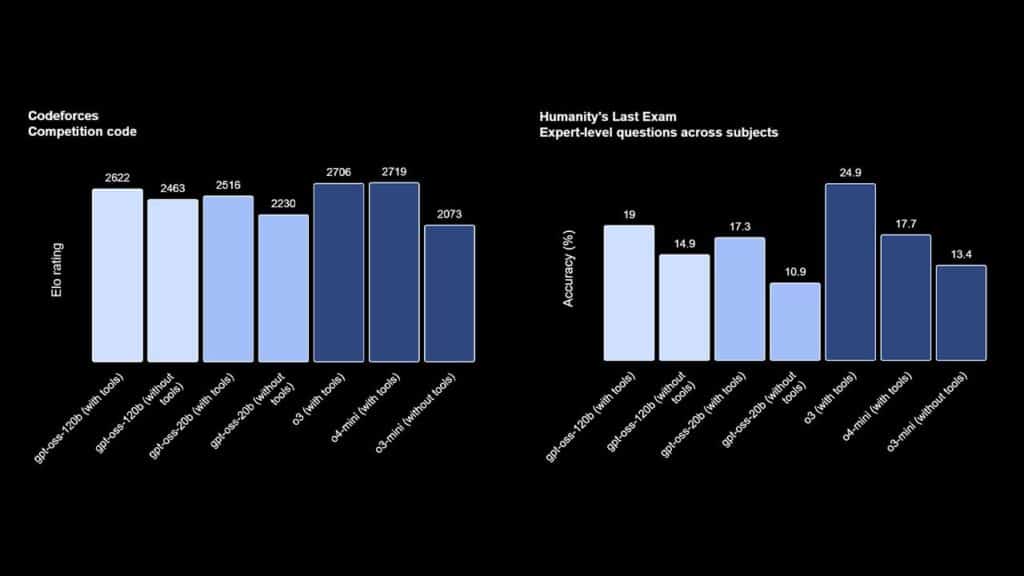

- gpt-oss-120b: casi igual a OpenAI o4-mini en benchmarks de razonamiento, corre eficientemente en GPU de ~80 GB.

- gpt-oss-20b: rendimiento similar a o3-mini en tareas generales, ideal para ejecutar en dispositivos con 16 GB de memoria.

| Modelo | Capas | Parámetros totales | Parámetros activos por token | Expertos totales | Expertos activos por token | Longitud de contexto |

| gpt-oss-120b | 36 | 117b | 5.1b | 128 | 4 | 128k |

| gpt-oss-20b | 24 | 21b | 3.6b | 32 | 4 | 128k |

Cómo agregar ChatGPT a tu WhatsApp y generar imágenes con IA

Casos de uso

GPT-OSS puede integrarse en una gran variedad de escenarios, por ejemplo:

- Asistentes de atención al cliente offline

Implementa chatbots que respondan consultas frecuentes sin exponer información sensible en la nube ni generar costos de API. - Generación de contenido y marketing automatizado

Crea descripciones de productos, posts de blog o anuncios adaptados al estilo de tu marca, directamente en tu infraestructura. - Soporte a desarrolladores y automatización de código

Usa GPT-OSS como copiloto local para autocompletar funciones, revisar pull requests o generar snippets de código sin compartir tu base de código externamente. - Análisis de datos confidenciales

Procesa y resume informes financieros, métricas de salud o datos de investigación dentro de tu propia red, cumpliendo con requisitos de privacidad. - Herramientas de productividad personal

Monta asistentes de toma de notas, corrección de estilo, traducción o planificación de tareas que funcionen completamente offline. - Educación y formación internalizada

Despliega tutores inteligentes para cursos internos, guías interactivas o simuladores de examen que no dependan de conexión y puedan personalizarse a tu currículo.

Cómo empezar con GPT-OSS

- Descarga el modelo gpt-oss-120b o 20b desde Hugging Face.

- Instala dependencias: Python 3.10+, PyTorch y

transformers. - Carga el modelo en tu script con un par de líneas de código:

from transformers import AutoModelForCausalLM, AutoTokenizer tok = AutoTokenizer.from_pretrained("openai/gpt-oss-120b") model = AutoModelForCausalLM.from_pretrained("openai/gpt-oss-120b")

- Ejecuta el modelo de forma local, ajusta parámetros de razonamiento (bajo/medio/alto) y desarrolla tu aplicación.

Ventajas y consideraciones

Ventajas

- Control total: datos y lógica en tu infraestructura.

- Sin costos recurrentes: cero cargos API y sin dependencia de internet.

- Personalización avanzada: fine-tuning sin licencias adicionales.

Consideraciones

- Requiere GPU con memoria adecuada (16 GB mínimo para 20B).

- Balance entre latencia y rendimiento según configuración de CoT.

- Mantén actualizados los parches de seguridad y evalúa riesgos de open-weight models.

Conclusión

GPT-OSS democratiza el acceso a IA de vanguardia, permitiéndote ejecutar y adaptar modelos de alta calidad en tu propio hardware sin cargos adicionales. ¡Descarga hoy gpt-oss en Hugging Face y comienza a potenciar tus proyectos con IA 100 % local!

FAQ

¿Cuál es la diferencia principal entre gpt-oss-120b y gpt-oss-20b?

El primero brinda mayor capacidad de razonamiento; el segundo es más ligero y apto para dispositivos con menor memoria.

¿Puedo usar GPT-OSS sin conexión a internet?

Sí, ambos modelos están diseñados para inferencia completamente offline.

¿Qué licencia tiene GPT-OSS?

Se publica bajo Apache 2.0, lo que permite usos comerciales y personales.

¿Necesito hardware especializado?

Para gpt-oss-120b se recomienda una GPU ≥ 80 GB; gpt-oss-20b funciona en GPUs ≥ 16 GB.

¿Dónde puedo descargar los modelos?

En el repositorio oficial de Hugging Face: openai/gpt-oss-120b y openai/gpt-oss-20b.

Tambien te puede interesar.